文献综述 AI 应用对比 — Elicit, GPTs 与 Perplexity

(注:本文为小报童精选文章,已订阅小报童或加入知识星球「玉树芝兰」用户请勿重复付费)

通过我的这些尝试,你无需再自己去摸索,可以直接根据我展示的结果选择合适的工具,更有效地进行文献回顾。

设定

本文要讨论的主题是文献综述中的 AI 应用效果,我们会对比 Elicit、GPTs 和 Perplexity 这几种工具。

具体来说,我们将进行一个实验,指定一个主题来测试不同的 AI 应用在搜寻相关文献方面的效果。我选择的主题是 “生成式 AI 在科研工作流中的影响”,这个主题源于我已经完成并发表在《图书情报知识》上的一篇论文。

由于这篇文章已经写完,所以我们不用担心即将展示的内容会对未来论文的发表产生任何影响。

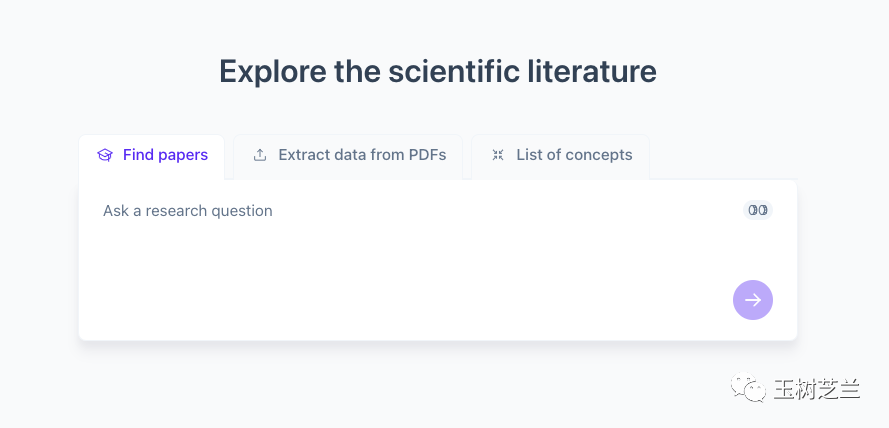

首先,我要用一个专业文献回顾工具,也就是我之前给你提到过的 Elicit。

Elicit

Elicit 的最新版本加入了文献综述功能,选项名称是 “寻找论文”。你可以提出笼统的问题,或像我这样用具体的提示词,说明自己的需求。

我的要求是做一个全面的文献回顾,主题已经明确,格式需要遵循 APA 标准。我要求 Elicit 查找大约 20 篇相关文献。最后,指出这些文献的局限性和不足,并找出现有研究的目标与研究现状之间的差异,即我们经常说的 “研究差距”(Research Gap)。发现这一差距,就是我们研究的扎实起点。

我还输入了一个启动思维链的提示词:“逐步思考”。然后,它很快就生成了一份综述。

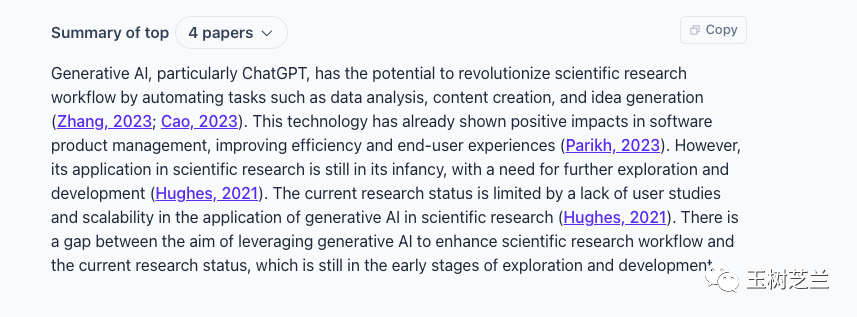

这份综述引用了一些非常新的文献,包括三篇 2023 年的和一篇 2021 年的。它确实提出了一些问题,指明了现在的局限,并特别指出了研究的差距所在。从结果来看,Elicit 的表现确实不错。

但你可能已经发现了一个问题:我们明明指定了需要 20 篇相关文献,而它只找到了 4 篇放在这里。

还没有评论,来说两句吧...